Katharina Zweig, Informatikprofessorin in Kaiserslautern, hat mit Ein Algorithmus hat kein Taktgefühl ein Buch geschrieben, das auf leicht verständlicher Ebene in die Thematik und Problematik der Künstlichen Intelligenz (KI) einführt. Im Vorwort schreibt sie:

„Das Buch besteht aus drei Teilen: Im ersten Teil des Buches präsentiere ich Ihnen die naturwissenschaftliche Methode der Erkenntnisgewinnung und stelle Ihnen schon mal Ihren Werkzeugkoffer für die Gestaltung von KI-Systemen vor. Im zweiten Teil geht es in den Maschinenraum, wo ich Ihnen das kleine ABC der Informatik erkläre: Algorithmus, Big Data und Computerintelligenz und wie sie zusammenhängen. Im dritten Teil geht es dann konkret um die Frage, wo die Ethik in den Rechner kommt und wie man diesen Prozess bestmöglich gestaltet. Dies Buch soll Ihnen das Werkzeug an die Hand geben, damit Sie sich einmischen können. Damit wir als Gesellschaft bessere Entscheidungen treffen können–sowohl mit als auch ohne Maschinen.“

Katharina Zweig sieht beide Seiten der Künstlichen Intelligenz:

„Und warum wird die künstliche Intelligenz überall Einzug halten? Zum einen, weil sie uns die lästigen, immer wiederkehrenden Teile der Arbeit abnehmen kann und damit Prozesse effizienter macht. Zum anderen sehe ich im Moment aber auch die Tendenz, dass künstliche Intelligenz dazu genutzt werden soll, Entscheidungen über Menschen zu treffen. Indem beispielsweise aus bestimmten Daten herausgelesen wird, ob eine Bewerbung zu einem Vorstellungsgespräch führen sollte, ob eine Person fit genug für ein Studium ist oder ob jemand vielleicht terroristische Neigungen hat.“

Algorithmen

Einer der Begriffe, die man in diesem Zusammenhang verstehen muss ist, der des Algorithmus. Das ist kurz gesagt, eine Handlungsanweisung zur Lösung eines definierten Problems, die in einzelne Schritte unterteilt ist. Algorithmen werden in der KI genutzt, um riesige Datenmengen nach Mustern oder Korrelationen zu durchsuchen.

Künstliche Intelligenz

Künstliche Intelligenz ist ein problematischer Begriff, weil er eine Analogie zu menschlicher Intelligenz nahelegt, die so eigentlich nicht vorhanden ist. Besser wäre es von maschinellem Lernen zu sprechen. Dabei lernt ein künstliches System mit Hilfe von Algorithmen aus Beispielen und kann diese am Ende der Lernphase verallgemeinern.

Gemeinhin unterscheidet man zwischen zwei Arten der KI. die schwache und die starke KI. Eine schwache KI kennt sich nur auf einem Problemgebiet aus und kann nur dort Probleme lösen. Ein Schachcomputer ist en gutes Beispiel für schwache Intelligenz. Auf dem Gebiet des Schach ist er ein Meister, aber mehr kann er nicht. Um zum Beispiel GO zu spielen, benötigt man einen anderen Algorithmus. Die meisten Beispiele, die gegenwärtig als KI angeführt werden, Übersetzungsprogramme, KI, die eigene Text schreibt, Bilderkennung, usw. fallen in den Bereich der schwachen KI..

Starke KI hat zum Ziel, dass sie die gleichen intellektuellen Fertigkeiten hat wie ein Mensch. Bisher gibt es noch keine Beispiele für eine starke KI, Man schätzt, dass man in 20 bis 40 Jahren eine starke KI entwickelt haben wird. Aber dieser Zeitraum ist eigentlich blosse Spekulation.

Wer sich für die dahinterliegenden philosophischen und ethischen Fragen interessiert, der findet in Life 3.0 von Max Tegmark ausreichend Stoff dazu.

Ein Werkzeugkoffer zur Beurteilung von Algorithmen

Entscheidungprozesse, die auf Algorithmen beruhen und von Maschinen getroffen werden, gibt es bereits viele und die Zahl wird noch wachsen. Von daher hält es Katharina Zweig nicht für sinnvoll und auch nicht für praktikabel, dass alle Algorithmen eine Prüfung unterzogen werden.

Algoskop

Im Wesentlichen müssen nach der Meinung von Zweig nur die Systeme geprüft werden, die

• über Menschen entscheiden oder

• über Ressourcen, die Menschen betreffen, oder die

• solche Entscheidungen treffen, die die gesellschaftlichen Teilhabemöglichkeiten von Personen ändern,

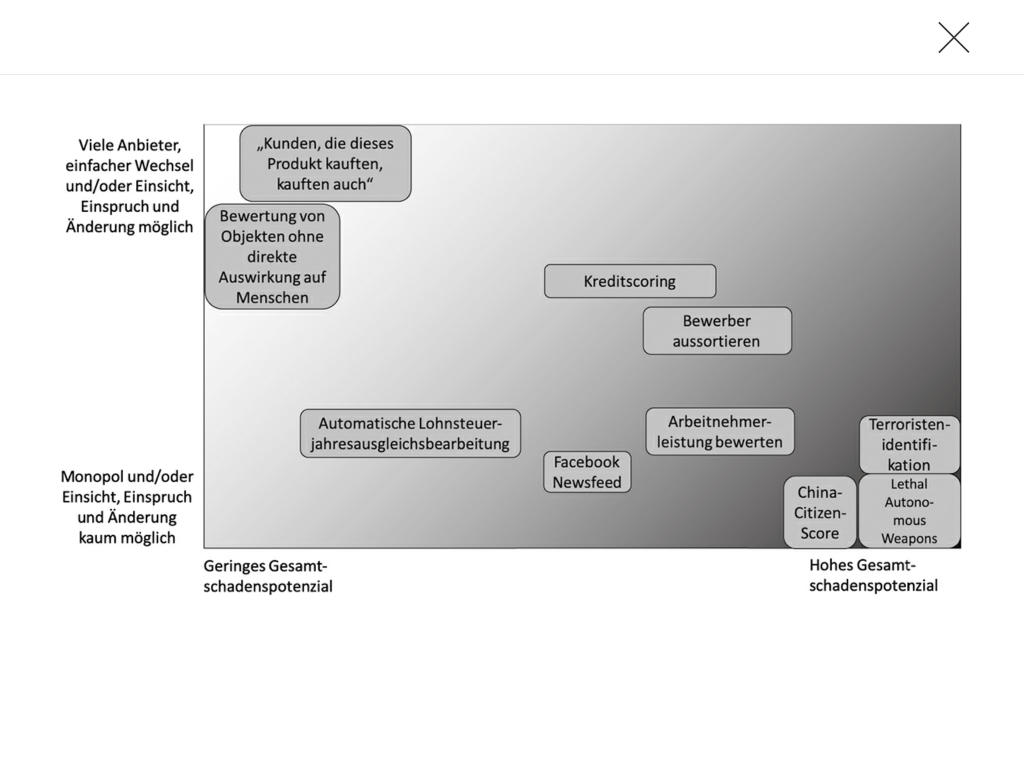

Daraus entwickelt Katharina Zweig eine Risikomatrix und beschreibt diese so:

Es gibt die folgenden drei Trends in der Risikomatrix:

• Ist ein algorithmisches Entscheidungssystem staatlich, wandert es auf der Monopol-Dimension nach unten, solange es keine Alternative gibt. Je mehr Widerspruchsmöglichkeiten und menschliche Ansprechpartner:innen es gibt, desto weniger monopolartig ist das Softwaresystem–daher kann sich diese Einschätzung durch analoge Widerspruchsmöglichkeiten verbessern.

• Ein personalisierter Dienst, der also jedem Nutzer und jeder Nutzerin andere Ergebnisse zeigt, ist wesentlich aufwendiger in seiner Blackbox-Analyse und bietet oftmals mehr Schadenspotenzial. Das System wandert von links nach rechts.

• Je mehr Betroffene es gibt, desto höher ist das individuelle Gesamtschadenspotenzial und meistens auch das gesamtgesellschaftliche Schadenspotenzial.

Nimmt man nun diese beiden Dimensionen–das Schadenspotenzial und die Möglichkeiten, fehlerhafte Entscheidungen zu entdecken, anzufechten und zu ändern–, dann kann man algorithmische Entscheidungssysteme in einer 2-D-Matrix danach anordnen. Die folgende Abbildung zeigt gleich einige exemplarische Einordnungen.

Diese Methode der Entscheidung nennt Katharina Zweig ihr Algoskop und bezeichnet es als erstes Werkzeug ihres Werkzeugkoffers.

OMA-Prinzip

Hat man mit dem Algoskop herausgefunden, dass man sich um diesen Algorithmus kümmern muss, kommt als zweites Werkzeug das OMA-Prinzip zur Anwendung.

Operationalisierung: Möchte man zum Beispiel den kürzesten Schulweg für Kinder herausfinden, muss man operationalisieren, was „der kürzeste Schulweg“ bedeutet. Soll er im Durchschnitt für alle Kinder kurz sein, darf er für kein Kind ein bestimmtes Maximum überschreiten? Diese Entscheidungen muss man dem Algorithmus mitteilen, da eine schwache Intelligenz ja nicht weiss, was ein Mensch mit „kürzestem Schulweg“ meint.

Modell des Problems: Dann ergibt sich die Frage, Woher kommen die dafür benötigten Daten, um die Länge des Schulweges zu berechnen? Sind es geschätzte Werte, oder reale, die durch Beobachtung ermittelt wurden? Wie und wodurch können sich die Daten im Lauf der Zeit verändern?

Algorithmus: Dies alles muss im Algorithmus berücksichtgt werden, damit er überhaupt aussagekräftige Eregebnisse liefern kann.

Lange Kette der Verantwortung

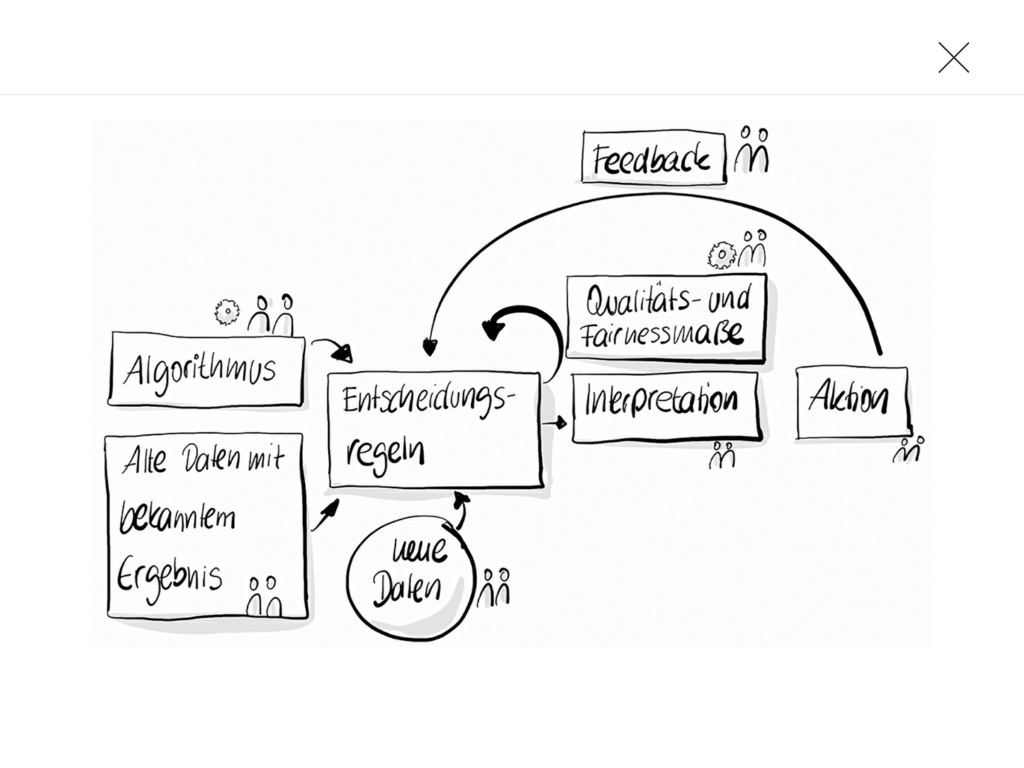

Es ist langer Prozess bis ein algorithmisches Entscheidungssystem zum Einsatz kommt, Das dritte Werkzeug von Katharina Zweig zeichnet diesen Weg nach und auch die Möglichkeiten, wo man sich einmischen soll.

Im Rahmen dieses Prozesses können nach Ansicht von Katharina Zweig folgende Fragen nützlich sein:

Daten: Welche sozialen Konzepte wurden wie operationalisiert?

Welche Daten wurden insgesamt verwendet?

Wie hoch ist die Qualität dieser Daten?

Wer definiert die Grundwahrheit?

Methode: Welcher Algorithmentyp wurde verwendet?

Passt der für die Menge der Daten oder ist er eigentlich zu datenhungrig?

Ist er fehlerstabil genug?

Ist das resultierende statistische Modell für Menschen nachvollziehbar?

Qualitäts-und Fairnessmaß: Welches Qualitätsmaß bzw. Fairnessmaß wurde verwendet?

Wer hat das jeweils entschieden?

Dateneingabe: Welche Fehlermöglichkeiten gibt es bei der Eingabe der Daten im laufenden Betrieb?

Interpretation: Wie wird das Ergebnis genau präsentiert?

Wer interpretiert es? Wurde die Person geschult?

Sind die Werte weiterer Qualitätsmaße bekannt?

Sind die Bedeutungen dieser Maße klar kommuniziert worden?

Aktion: Wer fällt die endgültige Entscheidung (» Aktion«)?

Ist die Entscheidung der Maschine autonom oder gibt es danach noch ein*e menschliche:n Entscheider*in?

Feedback: Ist das Feedback beidseitig ist oder nicht?

Wird das gemessen?

Wie?

Wie geht es in die Verbesserung des Systems ein?

Die Frage nach dem übergeordneten Ziel:

Wer hat das soziale Ziel festgelegt, das mit dem Einsatz einer Maschine verbessert werden soll?

Wie wird gemessen, ob es erreicht wird?

Für Systeme, die mit öffentlichen Geldern finanziert werden, würde ich noch folgende Kriterien hinzufügen:

Open Source::Ist der Quellcode des Algorithmus öffenlich zugänglich und nachvollziehbar?

Eigentum und Nutzungsrecht der Daten: Wem gehören die erhobenen Daten?

Wer darf sie nutzen?

Hat die Öffentlichkeit darauf Zugriff?

Vendor Lock-In: Passt das algorithmische Entscheidungssystem, einschliesslich der verwendeten Hardware und Protokolle in meine Systemumgebung, oder mache ich mich dadurch von einem Hersteller abhängig?

Messung der Regulierungsnotwendigkeit

Als viertes Werkzeug schliesslich gibt sie die Messung der Regulierungsnotwendigkeit an. Katharina Zweig sieht neben der Notwendigkeit der technischen Regulation, auch die der politischen Regulation und plädiert für einen Studiengang Sozioinformatik. Nähere Ausführungen zur politischen Regulation macht Katharina Zweig nicht.

Algorithm Watch

Katharina Zweig hat auch Algorithm Watch, mitgegründet, auf deren Website Auswirkungen algorithmischer Entscheidungsprozesse auf menschliches Verhalten beobachtet, analysiert und eingeordnet werden. Dort findet sich auch das ADM-Manifest, das in wenigen Sätzen das wesentliche Aussagen zusammenfasst.

Zum Schluss noch einige Videos, die weitere Informationen vermitteln.